Itt a legfrissebb közvélemény-kutatás: így áll most a Fidesz és a Tisza Párt

Továbbra is zajlik a közvélemény-kutatások „háborúja”, utánajártunk, mekkora a valós különbség a Fidesz és a Tisza között.

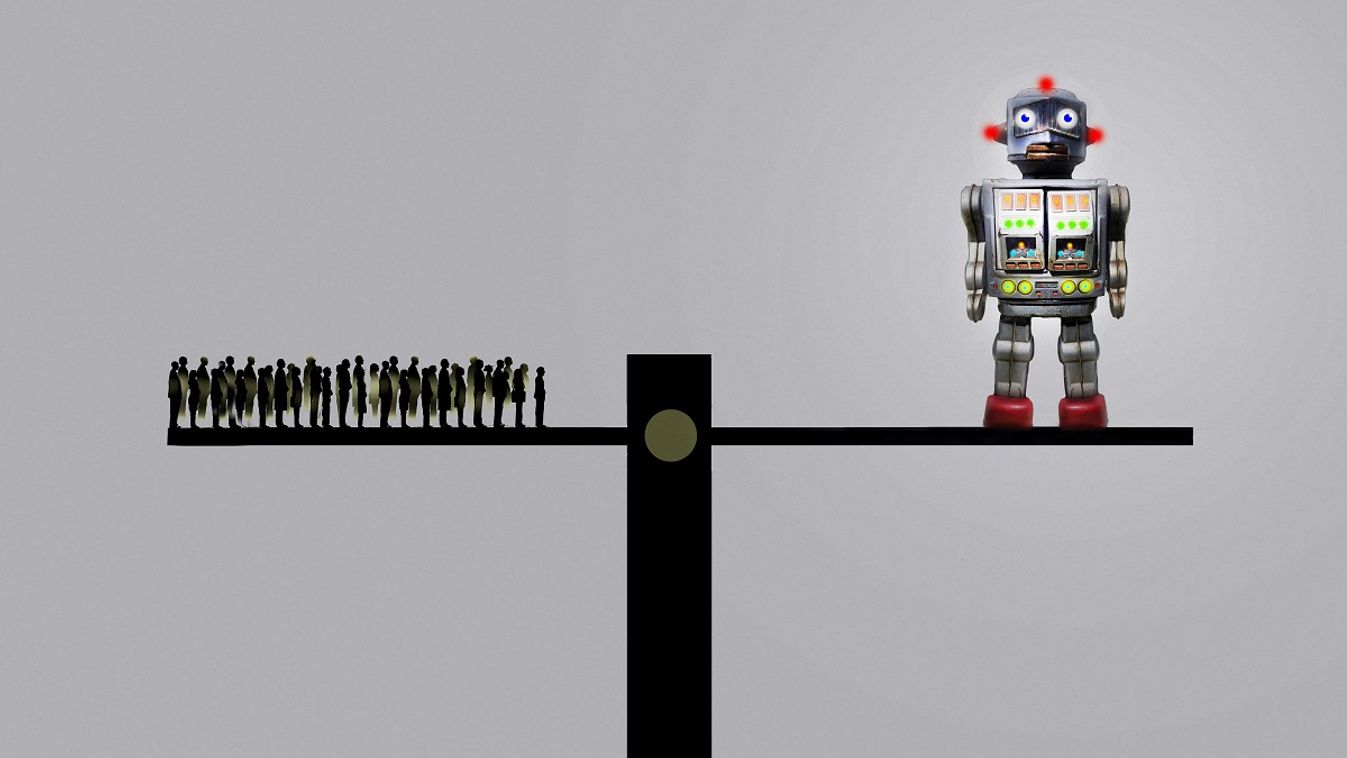

A szabályozatlan mesterséges intelligencia komoly veszélyt jelenthet az alapjogok érvényesülésére – derül ki egy NGO friss kutatásából a holland családtámogatási botrány kapcsán.

Diszkriminációnak és faji alapú profilalkotásnak adott zöld utat a holland kormányzat, amikor 2013-ban úgy döntött, hogy a gyermekek után járó állami támogatások rendszerét algoritmusokra bízza – tárta fel az Amnesty International nevű nem kormányzati szervezet (NGO) friss, „Idegengyűlölő gépek” (’Xenophobic Machines’) című jelentésében. A nemzetközi sajtóban „holland családtámogatási botrányként” futó ügy lényege, hogy a kormány hosszú éveken keresztül olyan mesterséges intelligencián alapuló algoritmusokat alkalmazott, amelyek

Az érintetteket az adóhatóság könnyebben minősítette adócsalónak, annak minden hátrányos jogkövetkezményével együtt.

Október 18-án a Velencei Bizottság is közzétette a maga elemzését a hollandiai családtámogatási botrányra vonatkozóan. Ebben a testület leírja, hogy „habár a családtámogatási ügy a kormányzat összes ágát komolyan és szisztematikusan érinti, úgy tűnik, hogy a jogállamiság követelményei (…) érvényesültek Hollandiában. (…) A kormányzat reakciója azonban sokkal több időt vett igénybe, mint amennyi indokolt lett volna, emiatt komoly kár érte az érintett családokat; azok pedig, akik a problémára felhívták volna a figyelmet, komoly ellenállásba ütköztek.”

A családokat ért kár jelentőségét talán megfelelően érzékelteti, hogy amellett, hogy az érintetteknek akár több százezer eurós nagyságrendben kellett pénz visszafizetni az államnak,

– derítette ki a holland központi statisztikai hivatal.

Több ezer ember életét tette tönkre a holland adóhatóság által alkalmazott technológia, miközben a feltárt hibákat még mindig nem javították ki, ennek megfelelően akár további jogsérelmek várhatók annak dacára, hogy a kormányzat megkezdte az érintettek kártalanítását.

A holland családsegélyezési rendszerben alapvetően a szülők és a gondviselők viselik a gyermekneveléssel kapcsolatos anyagi terheket. Ezt egészíti ki a holland kormány különböző családsegítési konstrukciókkal, amelyek összegét a szülők, gondviselők bevételéből kiindulva állapítják meg. Minden Hollandiában dolgozó vagy tanuló személy jogosult a gyermeknevelési segélyre amennyiben a gyermekét államilag regisztrált óvodába, napközibe íratta be.

Az alacsony jövedelmű háztartások a gyermeknevelési költségek akár 96 százalékára is jogosultak, míg a magas jövedelmű háztartások esetében ez az arány nagyjából 33 százalék. Ez elviekben azt jelenti, hogy a rendszer kijátszható azzal, ha a jogosultak valótlan adatokat szolgáltatnak a jövedelmi viszonyaikat, vagy a gyermek státuszát illetően.

Éppen ezért a 2013-as módosítást követően az adóhatóságok egy kockázatelemzésen alapuló öntanuló algoritmus útján kívánták csökkenteni a csalás veszélyét.

Pont járt többek között a jogosult állampolgárságáért is. A kérelemben az állampolgárságra vonatkozó kérdés igen/nem válaszlehetőségeket tartalmazott. Az a személy, aki a „nem” lehetőséget pipálta be, több kockázati pontot kapott, következésképpen az algoritmus szerint a kormányzati szemében a „nem holland” alanyok kockázati tényezőt jelentenek.

Az Amnesty International szerint ez a megoldás önmagában diszkriminatívnak számít. A pontozás útján ugyanis pusztán a holland állampolgárság ténye eleve kedvezőbb helyzetbe hozta a kérelmezőt, mint az adott esetben szintén rossz anyagi helyzetben lévő nem holland embertársát.

Ami még ennél is súlyosabb jogsérelmet feltételez, az az, ami az elvi feltételek gyakorlati megvalósulásával járt együtt. A származás alapú kockázatelemzés ugyanis számos visszaélésre és csalásra adott alapot Hollandiában, az adóhatóság pedig idővel kiemelt figyelmet kezdett fordítani a „nem holland” kérelmezők szűrésére. Hogy ezt még hatékonyabbá tegye, az algoritmus-alapú rendszert profilalkotásra is használta – ami eleve is tiltott a hatályos uniós adatvédelmi szabályozás értelmében (is), pláne, ha mindez diszkriminatív aktusoknak ágyaz meg.

A kockázatosként megjelölt kérelmező ügyével később már az adóhatóság szakemberei is foglalkozhattak. Történt például, hogy a rendszer nagyjából 120-150 ghánai származású kérelmezőt magas kockázatúnak ítélt, ennek eredményeképpen pedig a holland adóhatóság mind a 6047 ghánai származású kérelmezővel szemben gyanakvóvá vált. Fény derült arra is, hogy az adóhatóság munkatársai eleve becsmérlően fogalmaztak bizonyos népcsoportokkal kapcsolatban: a karibi térségből származó családokra csak úgy hivatkoztak, mint az „antilláki fészkek”.

Miután tehát a rendszer elkezdte kijelölni a „magas kockázatú” társadalmi csoportokat, az adóhatóság, érezve a nyomást, e csoportok megregulázásába kezdett.

Éppen ezért az adóhatóság a kockázatosnak ítélt csoportok soraiban kezdett el „tisztogatni”, visszakövetelve a vádak szerint jogtalanul kifizetett támogatást. A több ezer (bizonyos esetekben akár százezer) eurós összegeket is elérő, visszafizetést elrendelő határozatok elleni jogorvoslat az esetek igen jelentős részében hatástalannak bizonyult.

A fentiek a Transparency International értesülései szerint éveken keresztül a háttérben zajlottak, köszönhetően az algoritmus öntanulási mechanizmusainak. A mesterséges intelligencia területén alkalmazott úgy nevezett „fekete doboz” megoldás lényege, hogy az MI működtetője nem foglalkozik a rendszer belső működésével. Másképp fogalmazva:

Ezen elv szerint működött a holland adóhatóság kockázatértékelési algoritmusa is – a „jó kormányzás”, a jogállamiság és a legalitás elvének figyelmen kívül hagyása mellett.

Reinier van Zutphen ombudsman, elismerve, hogy Hollandiában a fentiek éveken keresztül ez volt a gyakorlat, még márciusban figyelmeztette a kormányt arra, hogy a hatóságoknak sokkal komolyabban kell vennie az etnikai alapú profilalkotást. Zutphen az etnikai profilalkotás 159 áldozatának esetét vizsgálva jutott a fenti következtetésekre.

Az eset Mark Rutte és liberális kormányának lemondásához vezetett még 2021 januárjának elején. Az erről szóló hírt itt olvashatja el.

Kép: Fanatic Studio / Gary Waters / SCIEN / FST / Science Photo Library via AFP

Dobozi Gergely