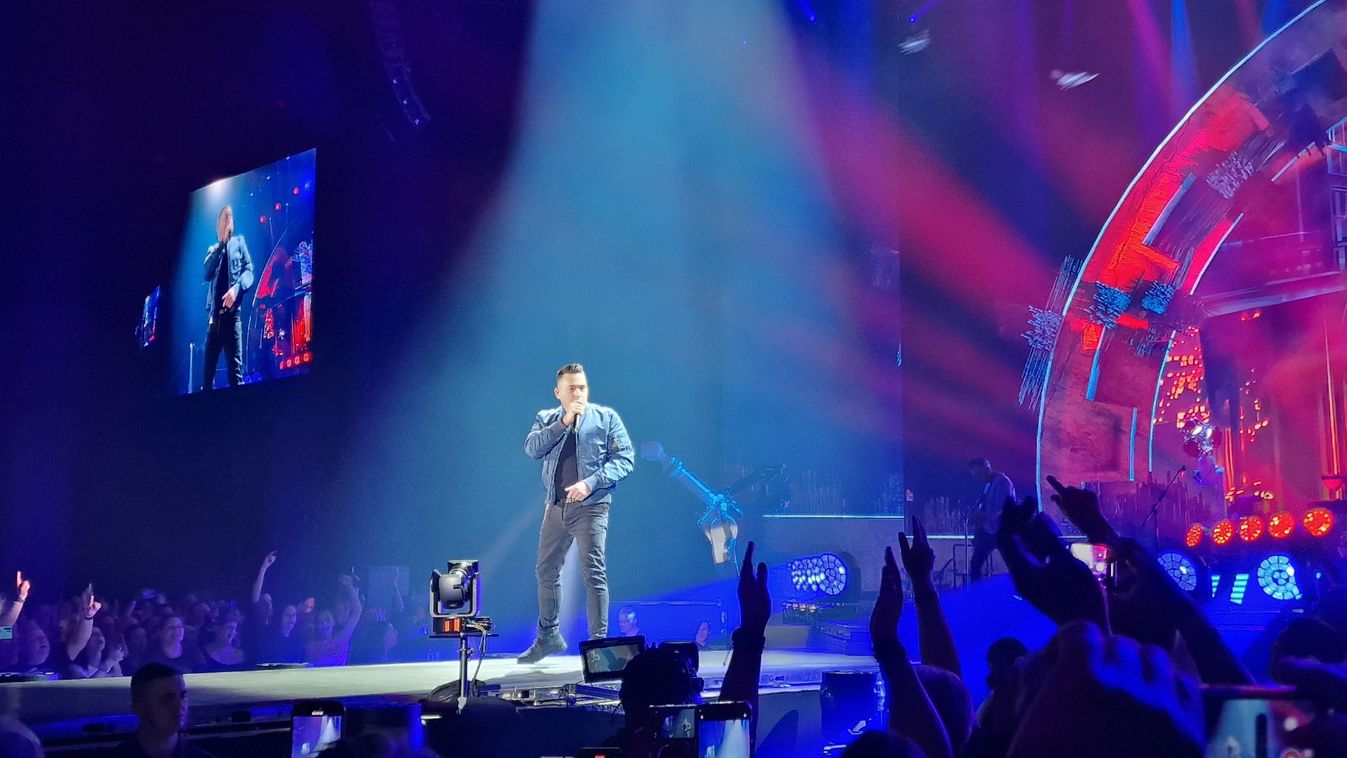

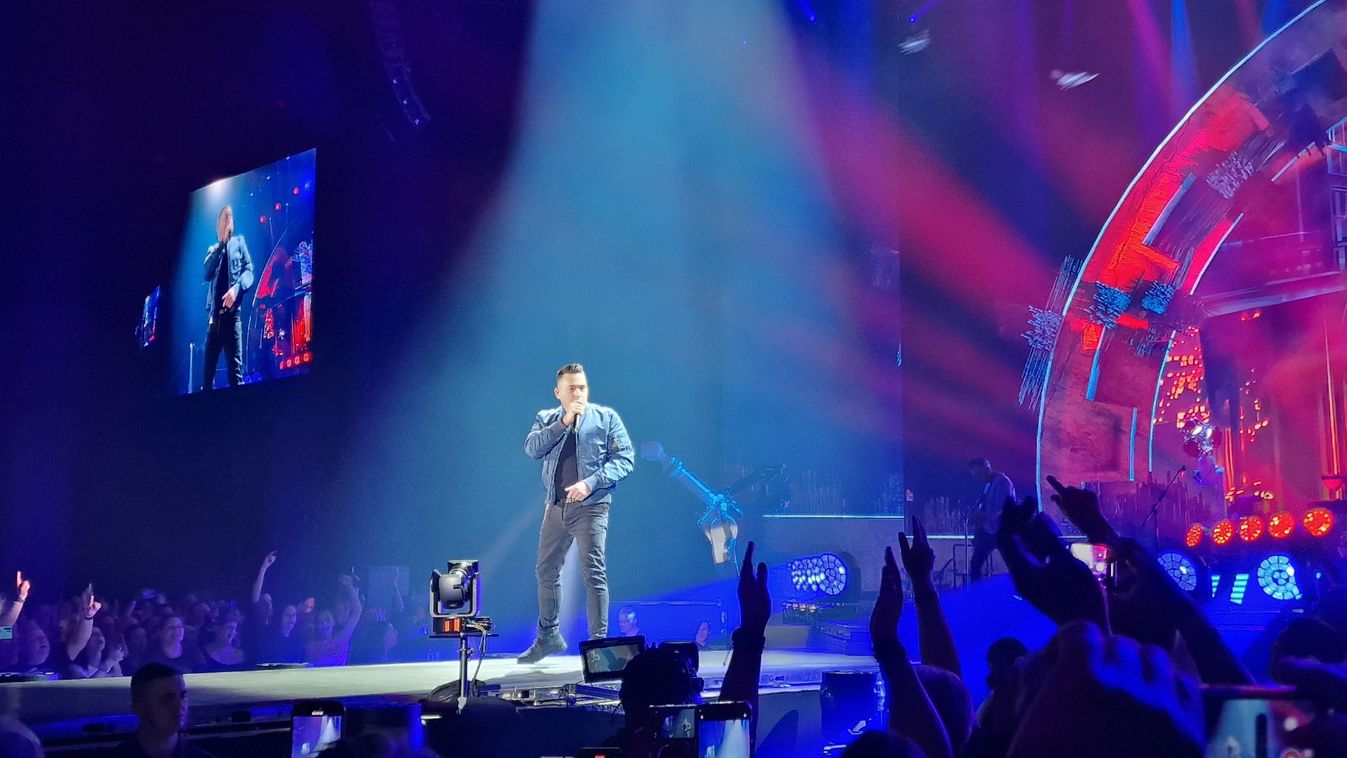

Ákos így lepett meg mindenkit a Papp László Sportarénában

Platina lemezzel és a múlt árnyaival vagy éppen fénylő szikráival Ákos lett Ákos előzenekara, hogy végül egy angyalnak monumentumot állítva a Metropolis épüljön fel.

Aki a mesterséges intelligenciát képes kordában tartani, az a korszak kihívásaival is sikerrel dacolhat. Ezért fontos, hogy az uniós szabályozás megfelelő körültekintés mellett készüljön el.

Big data = 21. század

Big data. Ez a két szó („sok adat”) a 21. században önálló fogalommá vált, s ha meg akarjuk érteni a 21. századi digitális forradalom lényegét, akkor ezt a fogalmat érdemes ízlelgetnünk – írja Alessandro Vespignani A jóslás algoritmusa című könyvében. Az, hogy mit tekintünk valóban „soknak”, igen relatív. Viszonyításképpen Vespignani is a svájci CERN (Európai Nukleáris Kutatási Szervezet) által néhány percenként előállított petabyteokat (1 petabyte = 1015 byte-nyi adat) veti össze azzal nagyjából 500 terabyte-nyi adattal, amelyet például a Facebook-felhasználók helyeznek el naponta a platformon.

Ennek fényében érthető, hogy miért készül diplomáciai irodát nyitni az Európai Bizottság az egyesült államokbeli Szilícium-völgyben, miközben Dánia a világon elsőként 2019-ben már meg is nyitotta sajátját. Itt fejlesztik és gyártják ugyanis azokat a chipeket, amelyek a big data-korszak motorjait jelentik – ezek ugyanis a mesterséges intelligencia működtetéséhez elengedhetetlennek számítanak.

Most kell szabályozni, most kell jól csinálni

A mesterséges intelligencia révén a számítógépek képesek az emberhez hasonló módon érzékelni a környezetet: adatokat fogadni, feldolgozni és a következtetések levonását követően reagálni az eseményekre. E néhány tulajdonság akár a mesterséges intelligencia definícióját is adhatná – a helyzet azonban nem ilyen egyszerű. A tárgykör összetettségét érzékelteti, hogy az uniós rendelettervezet készítői – más szempontok szerint – megkíséreltek ugyan definíciót adni a mesterséges intelligenciának, ez azonban számos több tanácsadó szervezet szerint sem sikerült kellően pontosan.

További gyengesége a tervezetnek, hogy meglehetősen szerteágazó alkalmazásmódoknak ágyaz meg ahelyett, hogy a harmonizációt segítené elő. Tulajdonképpen arról van szó, hogy egy bizonyos incidensre párhuzamosan több uniós tagállam hatósága is hatáskörrel rendelkezhet, amely elsősorban jogbiztonsági aggályokat vet fel, ráadásul épp a rendelettervezet szellemiségével ellentétes következményekkel járhat.

Számos alapjogi, adatvédelmi aggály is felmerül a tervezettel kapcsolatban. Egyike ezeknek a biometrikus azonosítás kérdése. A jogszabály-tervezet ugyanis jelen formájában tiltja ugyan a hatóságok számára, hogy a mesterséges intelligenciát valós idejű biometrikus személyazonosításra használják. Az azonban már nem tilos, hogy a hatóság kis idő elteltét követően használja a rendszert.

Kockázatos technológia

Mindez úgy hordoz lehetőségeket mint veszélyeket az emberiség számára, és ezzel az uniós jogalkotást előkészítő Európai Bizottság is tisztában van. Ahogy az a Bizottság a témával foglalkozó, úgy nevezett fehér könyvében is áll, a testület szerint a mesterséges intelligencia alkalmas arra, hogy a legérzékenyebb alapjogok érvényesülését sodorja veszélybe. Éppen ezért Brüsszel a tárgykörrel kapcsolatosan egyértelműen kockázatalapú megközelítést javasol. Ez lényegében azt jelenti, hogy egy adott mesterséges intelligencia alkalmazását főszabály szerint „magas kockázatúnak” kell tekinteni, különösen abban az esetben, ha alkalmazására

Szintén fontos szempont a magas kockázatú besorolás során az, hogy a mesterséges intelligencia alkalmazása hordozhatja-e sérülés, halál, jelentős anyagi vagy nem vagyoni kár kockázatát.

Korlátozott, illetve minimális kockázatot jelentenek a csevegőrobotokhoz, videójátékokhoz vagy spamszűrőkhöz hasonló rendszerek. Ezekről a felhasználó egyértelműen képes megítélni, hogy mesterséges intelligenciát alkalmaz, s ezen információ tudatában döntheti el, hogy folytatja-e a rendszer alkalmazását.

Az Európai Bizottság szerint léteznek olyan mesterséges intelligenciák is, amelyek „elfogadhatatlan mértékű kockázatot” hordoznak. Ide tartoznak azok a rendszerek, amelyek egyértelműen az emberek biztonságára, megélhetésére és jogaira jelentenek veszélyt. Ezek az alkalmazások ugyanis

képesek arra, hogy a felhasználók szabad akaratát megkerülve manipulálják az emberi viselkedést.

Ilyen rendszerek lehetnek azok a mesterséges intelligenciák, amelyek hangasszisztens-szolgáltatások útján képesek kiskorúakat veszélyes viselkedésre ösztönözni, vagy azok a rendszerek, amelyek lehetővé tehetik a kormányzatok számára a „társadalmi pontozást” (vagyis az alapjogok érvényesülésének meghatározott viselkedési pontszámhoz kötését).

Ki felel a károkért?

További problémát jelent a felelősség kérdése, vagyis, hogy kit lehet felelősségre vonni, ha a mesterséges intelligencia kárt okoz. Megjegyzendő, hogy ez a tárgykör annyira összetett és nehezen megfogható, hogy az Európai Bizottság jogalkotási javaslatában csak érintőlegesen foglalkozott a témával.

Pedig ahogy azt fentebb is rögzítettük, a mesterséges intelligencia képes az emberi felhasználótól függetlenül tanulni, s előre nem látható döntéseket hozni, ezzel pedig akár sérelmet is okozni.

Vespignani a mesterséges intelligenciáról szóló könyvében felidézi, hogy nem is olyan régen

Mind a Microsoft, mind pedig az IBM arcfelismerő szoftvere kudarcot vallott, amikor az arcfelismerő szoftver vizsgálatának színes bőrű nőket vetettek alá. Hasonlóan botrányos volt a Google képelemző szoftverének 2015-ös „baklövése”, amikor az alkalmazás egy fekete bőrű pár tagjait „gorillaként” címkézte.

Kép: Andrew Brookes / Image Source / Image Source via AFP

Dobozi Gergely